GPU란 무엇인가? – 인공지능 시대의 핵심 기술 총정리

안녕하세요, 빅보스쌤입니다.

요즘 인공지능(AI), 메타버스, 고성능 게임, 데이터 분석 등 다양한 분야에서 "GPU"는 단어를 자주 듣게 되시죠?

하지만 정확히 GPU가 어떤 기술이고 어디에 쓰이는지 헷갈리시는 분도 많을 겁니다.

이 글에서는 GPU의 개념부터 구조, 활용 분야, 최신 트렌드까지 한 번에 정리해드립니다.

초보자도 이해할 수 있도록 쉽게 설명드릴게요!

1. GPU(Graphic Processing Unit)란?

GPU( Graphics Processing Unit,그래픽 처리 장치)는 주로 그래픽 연산과 병렬 처리를 수행하는 프로세서입니다. PC가 동작하면서 이미지를 처리하기 위한 연산이 필요함에 따라 GPU가 필요합니다. 현재는 문서보다 이미지, 동영상으로 정보를 전달하는 경우가 많아지면서 더 빠르고 더 깨끗한 이미지, 동영상이 수요가 높아지고 있는데, 이를 위해선 고성능의 GPU는 필수적이다. 인공지능(AI), 데이터 분석, 과학 계산 등 다양한 분야에서도 사용됩니다.

2. GPU의 주요 특징

(1) 병렬 처리 성능

- GPU는 수천 개의 작은 연산 유닛(코어)을 가지고 있어 한꺼번에 많은 작업을 수행할 수 있습니다.

- 예: NVIDIA A100 GPU는 최대 6,912개의 CUDA 코어를 가지고 있습니다.

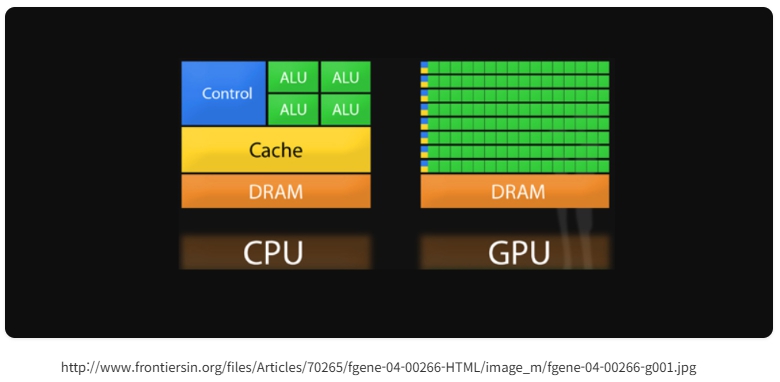

- CPU와 비교하여 GPU는 다수의 데이터 스트림을 병렬로 처리하는 데 특화되어 있습니다.

(2) 높은 부동소수점 연산 성능

- 과학 계산, 머신러닝, 그래픽 렌더링에서 대량의 실수 계산이 필요합니다.

- GPU는 부동소수점 연산(FP16, FP32, FP64) 성능이 매우 뛰어납니다.

- 예: AI 모델 학습에서 FP16 연산을 통해 속도와 메모리 효율성을 모두 확보합니다.

(3) 메모리 대역폭

- GPU는 메모리 대역폭이 매우 높아 대규모 데이터를 빠르게 전송할 수 있습니다.

- 최신 GPU에는 HBM2 또는 GDDR6 메모리가 탑재되어 있습니다.

- 예: NVIDIA H100 GPU는 HBM3 메모리를 통해 최대 3.6TB/s의 대역폭을 제공합니다.

(4) 그래픽 처리 능력

- 3D 모델링, 게임 그래픽, 영상 렌더링 등에서 필수적인 요소입니다.

- DirectX, OpenGL, Vulkan 등의 그래픽 API를 활용하여 실시간 렌더링을 수행합니다.

3. GPU의 구조

(1) 코어 (CUDA 코어/스트림 프로세서)

- GPU의 연산 유닛으로, 병렬 작업을 담당합니다.

- NVIDIA에서는 CUDA 코어, AMD에서는 스트림 프로세서로 부릅니다.

(2) 멀티프로세싱 유닛 (SM, CU)

- 여러 개의 코어를 묶어 구성한 유닛입니다.

- NVIDIA: SM(Stream Multiprocessor)

- AMD: CU(Compute Unit)

(3) 메모리 (VRAM)

- GPU의 자체 메모리로, 주로 GDDR6, HBM2, HBM3 등이 사용됩니다.

- 고속 연산 시 데이터 병목을 줄이기 위해 대역폭이 중요합니다.

(4) 캐시 메모리

- L1, L2 캐시를 통해 데이터 접근 속도를 높입니다.

- 최신 GPU는 L2 캐시 용량을 대폭 늘려 성능을 강화했습니다.

(5) 텍스처 유닛 (TMU)

- 그래픽 처리 시 텍스처를 샘플링하고 필터링하는 역할을 합니다.

(6) 렌더 출력 유닛 (ROP)

- 픽셀을 화면에 출력하는 마지막 단계로, 화면에 그리기 작업을 처리합니다.

4. GPU의 유형

| 유형 | 특징 | 예시 |

| 게이밍 GPU | 고해상도 그래픽, 실시간 렌더링 | NVIDIA GeForce, AMD Radeon |

| 데이터 센터 GPU | AI 연산, 딥러닝, HPC | NVIDIA A100, H100, AMD MI250 |

| 워크스테이션 GPU | CAD, 3D 모델링, 영상 편집 | NVIDIA Quadro, AMD Radeon Pro |

| 임베디드 GPU | 모바일, IoT 기기에 내장된 저전력 GPU | ARM Mali, Qualcomm Adreno |

5. GPU의 활용 분야

(1) 그래픽 렌더링

- 게임 그래픽, 3D 모델링, 영상 편집 등에서 주로 사용됩니다.

- 실시간 레이트레이싱(RTX)을 통해 사실적인 광원 효과를 구현합니다.

(2) 인공지능과 딥러닝

- 대규모 행렬 연산을 병렬로 처리하여 학습 속도를 대폭 향상합니다.

- GPU 클러스터를 통해 대규모 딥러닝 모델 학습이 가능해졌습니다.

- 예: ChatGPT 학습에 사용된 A100 GPU

(3) 과학 계산

- 유체 역학, 분자 모델링, 유전자 분석 등에서 고속 연산을 수행합니다.

- 고성능 컴퓨팅(HPC) 클러스터의 필수 요소입니다.

(4) 데이터 분석

- 대용량 데이터를 병렬로 처리하여 분석 속도를 개선합니다.

- CUDA를 이용한 GPU 가속 데이터베이스 처리 등도 가능.

(5) 블록체인과 암호화폐 채굴

해시 연산을 병렬로 처리하여 채굴 속도를 높입니다.

6. GPU와 CPU 비교

| 특성 | CPU | GPU |

| 처리 성능 | 직렬 처리 (높은 단일 코어 성능) | 병렬 처리 (수천 개의 코어) |

| 연산 속도 | 적은 코어로 복잡한 연산 처리 | 많은 코어로 간단한 연산 병렬 처리 |

| 활용 분야 | 일반 컴퓨팅, OS 제어, 복잡한 논리 연산 | 그래픽 처리, 딥러닝, 대용량 데이터 분석 |

| 전력 소비 | 비교적 낮음 | 고성능 모델은 전력 소모가 큼 |

7. GPU 프로그래밍 언어

- CUDA (NVIDIA 전용):

- NVIDIA GPU에서 사용할 수 있는 병렬 컴퓨팅 플랫폼입니다.

- 딥러닝 프레임워크(PyTorch, TensorFlow)에서도 널리 사용됩니다.

- OpenCL (AMD 및 다목적):

- GPU와 CPU 모두에서 사용할 수 있는 범용 병렬 프로그래밍 언어입니다.

- DirectCompute & Vulkan:

- 그래픽과 연산을 동시에 처리하는 API로, 게임과 그래픽 애플리케이션에서 사용됩니다.

8. 최신 GPU 트렌드

- HBM3 메모리 탑재: 대역폭 극대화로 AI와 HPC 성능 향상

- GPU 클러스터: 수백 대의 GPU를 연결하여 딥러닝 학습 속도를 극대화

- AI 전용 GPU: Tensor 코어와 같은 AI 가속 유닛을 내장하여 딥러닝 속도 개선

- 저전력 GPU: 모바일 기기와 엣지 컴퓨팅용으로 전력 효율을 극대화한 모델

📝 마무리: 왜 GPU는 지금 중요한가?

GPU는 단순히 게임용 그래픽카드를 넘어서

AI, 데이터 분석, 과학 계산, 영상 산업 등

미래 산업의 핵심 인프라로 자리잡고 있습니다.

지금이 바로 GPU를 제대로 이해하고 활용하는 시대입니다.

앞으로도 GPU 기술은 더 발전할 것이며, 우리의 일상과 산업을 더욱 바꾸게 될 것입니다.

🔔 궁금한 GPU 정보나 비교가 있다면 댓글로 남겨주세요!

♥️ 도움이 되셨다면 공감과 공유도 큰 힘이 됩니다 :)

📌 빅보스쌤 블로그에서는 AI, IT 트렌드, 기술 자격증, 실무 노하우 등 다양한 콘텐츠를 소개합니다!

'정보기술 동향' 카테고리의 다른 글

| 2025년 Google Gemini(제미나이) AI 주요 변경 사항 (2) | 2025.04.02 |

|---|---|

| 지브리 화풍에 사용되는 AI GPU란 - 특징, 활용분야 (12) | 2025.04.01 |

| 파이썬(python)이란 무엇인가? - 장단점 및 설치방법 (4) | 2025.03.30 |

| 차세대 영상 생성 AI 모델 Sora 뭐야? - 개념, 특징 및 사용법 (0) | 2025.03.28 |

| ChatGPT vs Gemini vs Claude 비교 - 심층리서치 (12) | 2025.03.26 |